Berada di era Industry 4.0 saat ini, pemanfaatan Big Data dalam perusahaan menjadi satu kebutuhan yang crucial dan tidak dapat dielakkan lagi. Setiap lini perusahaan yang ingin dapat beradaptasi dengan perubahan pasar yang cepat harus dapat memanfaatkan Big Data menggunakan teknologi yang ada.

Tentunya dibalik kemampuan perusahaan dalam menganalisa data, dibutuhkan teknologi yang dapat mengkomputasi data dalam jumlah yang sangat banyak dan mampu menerapkan Artificial Intelligence atau kecerdasan buatan di dalam sektor yang tepat menggunakan algoritma Machine Learning.

Bukan hanya itu saja, adanya tim Data Analyst atau Data Scientist di dalam sebuah perusahaan juga berperan dalam pemanfaatan Big Data untuk membuat keputusan-keputusan yang tepat.

Vertica adalah database MPP yang dirancang untuk Big Data dan memiliki fungsi-fungsi Machine Learning bawaan (In-Database Machine Learning). Proses menganalisa data yang cukup panjang (Data Science Cycle), yang biasanya membutuhkan berbagai macam tools, sekarang sudah disediakan oleh Vertica untuk melakukannya dengan hanya menggunakan query saja.

Algoritma-algoritma Machine Learning standar yang biasanya diperlukan untuk membuat pemodelan, baik supervised technique (classification & regression), maupun unsupervised technique (clustering, dimension reduction, dsb) semuanya sudah tersedia di dalam Vertica dan sudah pernah diterapkan ke berbagai macam sektor industri.

Anomaly Detection in Manufactures using Vertica

Manufactures adalah salah satu sektor yang dapat diterapkan fungsi Machine Learning, yaitu salah satunya untuk keperluan anomaly detection. Dengan adanya pemanfaatan data-data sensor yang tepat, kita dapat membuat pemodelan behavior mesin yang tepat, dimana sebelumnya harus menggunakan pemodelan simulasi mesin yang rumit, seperti menggunakan software MatLab.

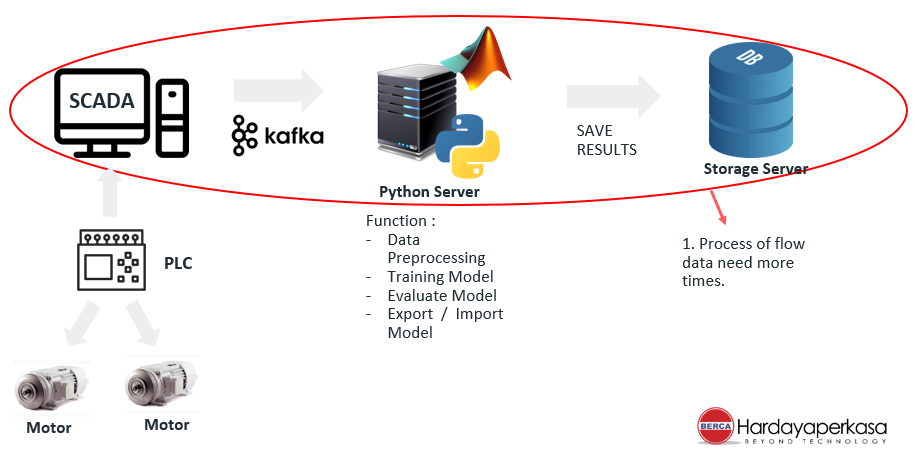

Berikut adalah contoh topologi penerapan Vertica untuk keperluan anomaly detection.

Data-data dari sensor yang dipasang pada motor akan dibaca oleh PLC, kemudian dikirim ke main center yang mengumpulkan seluruh data, contohnya SCADA. Data dari SCADA dapat diperoleh menggunakan Kafka connector dan di-ingest ke dalam database Vertica dan di-create menjadi tabel. Setelah menjadi tabel, baru setiap Machine Learning function dapat kita terapkan untuk membuat model. Selanjutnya model yang sudah jadi dapat kita export ke dalam formal PMML untuk keperluan scoring atau di-import kembali ke dalam database Vertica untuk digunakan kembali.

Keuntungan menggunakan topologi seperti ini adalah apabila jumlah data-data yang dikumpulkan dari sensor-sensor bertambah, tentu saja kita memerlukan storage yang lebih besar untuk menampung data dan unit processing yang lebih banyak untuk menganalisa data. Disini, kita hanya perlu menambah jumlah cluster Vertica saja, maka kita sudah mendapatkan kedua-keduanya, baik jumlah storage maupun jumlah unit processing.

Sementara old solutions, biasanya akan menggunakan server yang terpisah untuk keperluan storage maupun analytics. Kerugiannya, diperlukannya cost time yang lebih, karena data berpindah dari server analytics ke server storage (data tidak berada dalam satu storage yang sama.)

Kerugian lainnya, apabila volume data bertambah, maka diperlukan cost lebih banyak untuk melakukan scalling terhadap server storage dan server analytics.

Flow Data Science Cycle For Anomaly Detection

Berikut adalah tahap-tahap yang harus dikerjakan untuk membuat pemodelan untuk anomaly detection.

Berikut adalah contoh penerapannya di Vertica langsung hanya menggunakan SQL saja.

- Data exploration

Mencari korelasi antar variabelnya dan summary statistic-nya.

- Data Preparations

Memproses categorical variable menjadi numeric variable.

- Unsupervised ML

Membagi data menjadi 2 cluster antara data anomaly dengan data yang normal menggunakan algoritma K-Means

- Supervised ML

Menggunakan algoritma Logistic Regression untuk membuat pemodelan anomaly classification.

- Evaluation

Menggunakan confusion matrix untuk mengevaluasi seberapa baik pemodelan yang telah kita buat dalam memprediksi data-data sensor yang baru.

Selanjutnya, pemodelan tersebut dapat di-export ke dalam format PMML dan dapat digunakan untuk keperluan scoring di platform yang lainnya.

Predictive Maintenance Results

Setelah kita mendapatkan model untuk anomaly detection, kita dapat mengembangkan model tersebut dengan menambahkan timeseries forecasting, seperti menggunakan algoritma ARIMA (Auto Regression – Moving Average) atau Deep Learning Neural Network, seperti LSTM (Long Short Term Memory) untuk dapat memprediksi curva sensor beberapa hari ke depan. Sehingga dapat diprediksi kapan motor harus diganti atau diservice sebelum ada kerusakan yang fatal.